Дипфейки в политике: Восточная Европа, Китай, Индия

В предыдущей публикации этой серии инициатива Azbuka media рассказывала про дипфейки в политике США и Евросоюза. Начавшись как сатира в американском информационном поле, фейки на основе искусственного интеллекта оказались быстро включены в арсенал манипуляторов. Их стали использовать в политической борьбе, формировании общественных настроений и даже для достижения военных целей.

В нашей сегодняшней публикации продолжим разбираться во влиянии дипфейков на общественно-политическую сферу. На очереди страны Восточной Европы и передовые азиатские государства. Как дипфейки используются в пропаганде? И как искусственный интеллект влияет на политику? Читайте ниже.

Дипфейк — это синтетическое медиа (видео, аудио или изображение), созданное с помощью технологий искусственного интеллекта (ИИ), способное правдоподобно имитировать реальных людей.

Россия — война и информационные вбросы

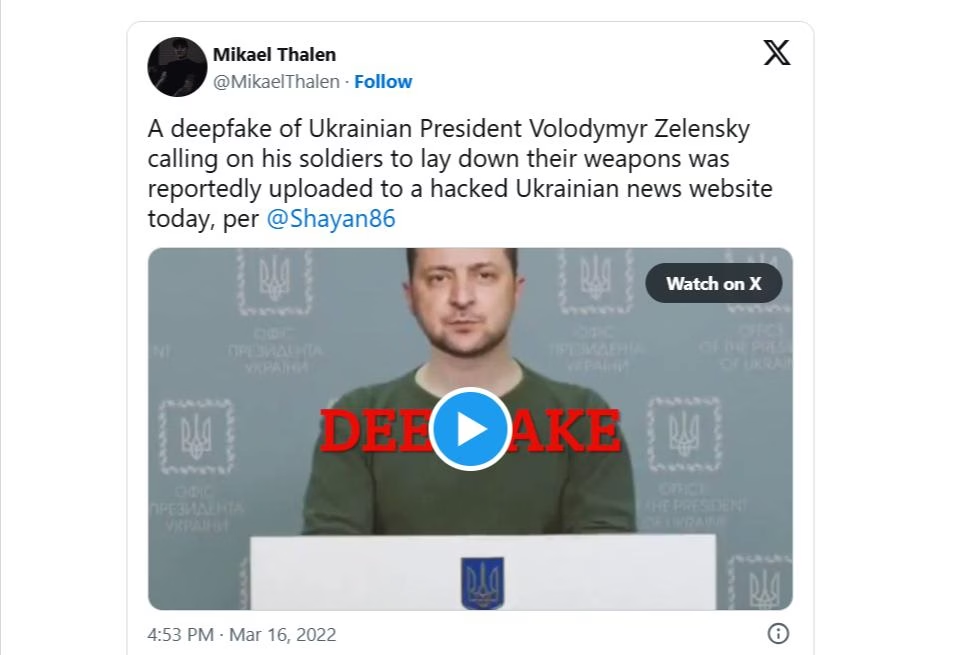

В разгар полномасштабного вторжения РФ в Украину появился, видимо, первый военный дипфейк. 16 марта 2022 года на взломанном новостном сайте и в соцсетях распространилось поддельное видео от имени президента Украины Владимира Зеленского.

В коротком ролике сгенерированное изображение Зеленского обращалось к украинским войскам с призывом сложить оружие и сдаться России. Ролик заливали в Facebook, YouTube, Х и на российские платформы. Но качество подделки было не идеальным — многие сразу заметили неестественный акцент и мимику, и фейк оперативно разоблачили.

Дипфейк-ролик с Владимиром Зеленским стал первым примером использования искусственного интеллекта для дезинформации в вооружённом конфликте / Скриншот публикации пользователя Х Mikael Thalen

Предполагается, что видео было изготовлено пророссийскими силами как элемент информационной войны, чтобы посеять панику и сломить сопротивление Украины, деморализовав её армию и население. Фейковое видео просуществовало недолго, западные соцсети быстро удалили его за нарушение политик, и оно не оказало влияния на ход войны. Однако же подобный продукт получил широкий международный резонанс как первый пример применения дипфейка в реальном конфликте. После инцидента украинские ресурсы и западные соцсети усилили модерацию, чтобы не допустить новых опасных дипфейков.

В июне 2023 года уже Россия стала жертвой подобной операции. Хакеры взломали трансляции в нескольких регионах РФ (в особенности приграничных с Украиной) и пустили в эфир поддельное экстренное обращение президента Владимира Путина. «Путин» объявил, что украинские войска при поддержке НАТО вторглись в Брянскую, Белгородскую и Курскую области. Поддельный лидер декларировал введение военного положения, всеобщую мобилизацию и призывал население к эвакуации вглубь страны.

Видео, в котором дипфейк Путина сообщает о вторжении украинских войск и НАТО в Россию

Вероятно, акцию провели проукраинские кибердиверсанты. Власти РФ намекнули на украинский след и «игру ИИ». Кремль уже через несколько минут опроверг «речь» — пресс-секретарь Дмитрий Песков заявил, что это «всё неправда, системы взломаны». Случай продемонстрировал уязвимость и России к информационным атакам.

Беларусь — дипфейк как голос оппозиции

В Беларуси применение дипфейков тоже дало о себе знать, хотя и неожиданным образом. Если в большинстве стран фальшивые медиа используются для обмана, то белорусские демократические силы попробовали задействовать ИИ, чтобы обойти цензуру.

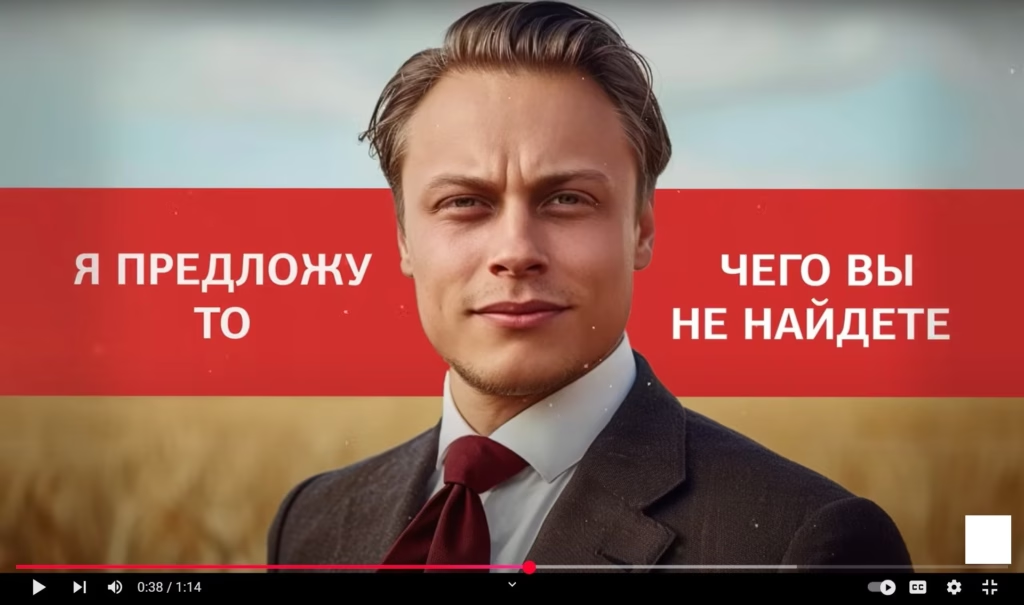

В феврале 2024 года команда Светланы Тихановской создала виртуального политика для парламентских выборов в Беларуси. Проект получил название «Ясь Гаспадар» — это полностью сгенерированный искусственным интеллектом «кандидат», у которого нет реального прототипа. Оппозиция с помощью нейросетей создала образ вымышленного человека, записала от его имени видеообращения и пыталась распространять их в соцсетях и мессенджерах как агитацию.

Ясь Гаспадар — продукт белорусской оппозиции

Цифровые показатели роликов оказались не очень высокими. Однако проект получил некоторый отклик в западных медиа как любопытный прецедент использования дипфейка.

Китай — «синтетические» новости и информационные кампании

Китайская Народная Республика известна мощной государственной пропагандой и цензурой, и в последние годы Пекин активно осваивает синтетические медиа. Здесь примечательны два направления: внутреннее использование цифровых ведущих новостей и внешние операции с дипфейк-видео в социальных сетях.

Ещё в 2018 году китайское госинформагентство Синьхуа представило цифрового диктора новостей по имени Цю Хао, созданного на базе ИИ.

Данный аватар, имитирующий внешность и голос реального человека, был способен «работать» круглосуточно и зачитывать любые тексты. Несмотря на энтузиазм публики к технологической новинке, широкого применения он не нашёл. Однако вскоре технологии усовершенствовались, и в 2022–2023 годах Китай начал применять дипфейк-ведущих в своих информационных кампаниях, нацеленных вовне. Пример — сеть фейковых новостных видео «Wolf News», обнаруженная аналитиками в 2023 году.

Видео «Wolf News» рассылались бот-аккаунтами на Facebook, X и YouTube, нацеливаясь на западную аудиторию. В этих роликах англоязычные ведущие (мужчина «Джейсон» и женщина «Анна») с профессиональным видом рассказывали новости в выгодном для Пекина ключе.

Цифровые ведущие Джейсон и Анна, созданные Китаем для продвижения своей повестки / Скриншот The Record

На деле же «ведущие» оказались аватарами, купленными через британский сервис Synthesia. А «Wolf News» был просто вымышленным медиа-брендом.

После раскрытия сеть «Wolf News» заблокировали на платформах. На практике эффект был невелик — качество видео низкое, большинство роликов набирали считанные сотни просмотров. Тем не менее, это тревожный сигнал о появлении доступных инструментов для массового производства дипфейк-пропаганды по шаблону.

В самом Китае в январе 2023 года вступили в силу новые правила, обязывающие помечать ИИ-контент и запрещающие дипфейки, искажающие новости. Иронично, что Пекин законодательно ограничивает дипфейки внутри страны, но госструктуры КНР поддерживают их использование во внешней пропаганде.

Индия — мультиязычные агитролики и угроза дезинформации

В феврале 2020 года во время выборов в законодательное собрание Дели произошёл первый задокументированный случай использования дипфейка в индийской политической кампании. Правящая партия Бхаратия Джаната (BJP) создала два варианта видео с обращением своего лидера Маноджа Тивари: в одном он говорил по-английски, в другом — на диалекте харьянви, которого на деле не знает.

Клипы выглядели реалистично, речь артикулирована синхронно. Их целью было расширить охват агитации, обратившись к разным языковым группам избирателей.

Распространение шло скрытно через личные пересылки, избегая публичных платформ. Было задействовано около 5 800 WhatsApp-групп по Дели и пригородам, где видео разошлось вирусно, охватив до 15 миллионов человек. BJP заявила о «воодушевляющем отклике» — по словам организаторов, многие избиратели поверили дипфейку и позитивно отреагировали.

Однако факт использования дипфейк-технологии вызвал тревогу у индийских экспертов и прессы. После выборов в Индии активизировались дискуссии о регулировании политических дипфейков. Журналисты отметили, что подобный «генеральный прецедент» выпустил джинна из бутылки: теперь, когда одна партия применила дипфейк легально, ничто не помешает другим силам делать более злонамеренные подделки. И действительно, уже в 2021–2022 годах фиксировались случаи, когда в соцсетях появлялись фейковые аудио или видео, порочащие политиков.

Индийское законодательство пока не содержит прямого запрета на дипфейки. Зато существуют нормы против информационного мошенничества и клеветы, под которые злоупотребления искусственным интеллектом могут подпадать.

«Фейк во спасение»

Любопытны и случаи, когда политики пытались опровергнуть реальные утечки тем, что это дипфейк представляет собой так называемый «деверсификационный эффект». Например, в 2019 г. в Малайзии при скандале с интимным видео одного из министров сторонники заявляли, что запись могла быть дипфейком (хотя прямых доказательств этому не представили).

Подобное спекулятивное обвинение в дипфейке для дискредитации или защиты стало новой тактикой: технология позволяет правдоподобно отрицать достоверность компромата, даже если он реален. Это формирует «дивиденд лжеца» — злоумышленники могут отвергать любые улики, называя их дипфейками, что подрывает само понятие правды в информационном пространстве.

Заключение: дипфейки в политике — от угроз до перспектив

С 2017 года технология дипфейк прошла путь от курьёзных экспериментов до реального инструмента политической борьбы. Случаи по всему миру, от американских выборов до войны в Украине, подтвердили опасения: дипфейки могут быть использованы для дезинформации, манипуляции мнениями в социуме и подрыва доверия.

Пока что ни один инцидент не привёл к катастрофическим последствиям. Часто их быстро разоблачали, и влияние было точечным. Однако тенденция настораживает: по мере улучшения качества генерации и доступности искусственного интеллекта такие фейки могут становиться всё более убедительными. В ответ государства начинают вводить законы, а платформы — фильтры, но остаётся риск, что злоумышленники найдут обходные пути или воспользуются моментом, когда проверка затруднена — как это было в Словакии перед голосованием.

В то же время, возник и обратный эффект: политики и пропагандисты стали ложно заявлять, что разоблачённые реальные видео — это дипфейк, тем самым избегая ответственности. Такой «дивиденд лжеца» подрывает саму возможность отличить правду от подделки, если априори падает доверие ко всем материалам.

Таким образом, вызов дипфейков носит двоякий характер: нужно и предотвращать умышленные фальсификации и поддерживать доверие к подлинным доказательствам. С 2017 по 2025 годы мир сделал первые шаги к решению этой проблемы — созданы прецеденты правового реагирования, разработаны технологии определения, улучшилась осведомлённость. Но впереди, вероятно, новые, ещё более изощрённые попытки применения ИИ в пропаганде.

@bajmedia

@bajmedia